PRESENTASI TUGAS AKHIR – KI091391 -...

Transcript of PRESENTASI TUGAS AKHIR – KI091391 -...

26 Juli 2013 Tugas Akhir – KI091391 1

IMPLEMENTASI KD-TREE K-MEANS CLUSTERING PADA KLASTERISASI DOKUMEN

(Kata kunci: KD-Tree K-Means Clustering, Klasterisasi Dokumen, K-Dimensional Tree, K-Means Clustering)

PRESENTASI TUGAS AKHIR – KI091391

Penyusun Tugas Akhir :Eric Budiman Gosno(NRP : 5109.100.153)

Dosen Pembimbing :Isye Arieshanti, S.Kom, M.Phil.

Rully Soelaiman, S.Kom., M.Kom.

10 Juli 2013 Tugas Akhir - KI091391 2

TAHAPAN PRESENTASI

Latar Belakang

Rumusan Masalah

Batasan Masalah

Tujuan

Pendahuluan

Sistem Klasterisasi Dokumen

Uji Coba

Kesimpulan dan Saran

K-Means Clustering sensitif terhadap inisialisasi posisi titik tengahklaster. Inisialisasi posisi titik tengah yang buruk akan algoritmaK-Means Clustering menghasilkan solusi local optimum.

KD-Tree K-Means Clustering adalah perbaikan dari metode K-Means Clustering dengan inisialisasi titik tengah klastermenggunakan struktur data K-Dimensional Tree dan nilaikerapatan/density

Hasil evaluasi oleh Redmond et al tidak melingkupi performa KD-Tree K-Means Clustering pada data set dokumen.

26 Juli 2013 Tugas Akhir – KI091391 3

LATAR BELAKANG

26 Juli 2013 Tugas Akhir – KI091391 4

1. Bagaimana mengimplementasikan algoritma KD-Tree K-Means Clustering pada kasus klasterisasi dokumen?

2. Bagaimana hasil dan performa dari algoritma KD-Tree K-Means Clustering dibandingkan dengan metode K-Means Clustering pada kasus klasterisasi dokumen?

RUMUSAN MASALAH

26 Juli 2013 Tugas Akhir – KI091391 5

1. Data set yang digunakan untuk uji performa implementasi padaklasterisasi non dokumen adalah data set Pen-Based Recognition of Handwritten Digits(http://archive.ics.uci.edu/ml/datasets/Pen-Based+Recognition+of+Handwritten+Digits) dan data set Image Segmentation (http://archive.ics.uci.edu/ml/datasets/Image+Segmentation)dari UCI Machine Learning Repository.

2. Data set yang digunakan untuk uji performa pada klasterisasidokumen adalah data set 20 newsgroup dari KDD UCI Archive (http://kdd.ics.uci.edu/databases/20newsgroups/20newsgroups.html)

3. Algoritma yang digunakan sebagai perbandingan performa KD-Tree K-Means pada klasterisasi dokumen adalah K-Means Clustering dengan inisialisasi Forgy’s Method

BATASAN MASALAH

26 Juli 2013 Tugas Akhir – KI091391 6

4. Parameter evaluasi yang digunakan adalah distorsi euclideandistance dan Normalized Information Gain

5. Metode stemmer yang digunakan pada pra proses dokumenadalah porter stemmer

BATASAN MASALAH

26 Juli 2013 Tugas Akhir – KI091391 7

1. Mengimplementasikan algoritma KD-Tree K-Means Clustering dalam permasalahan klasterisasi dokumen.

2. Melakukan uji performa dari algoritma KD-Tree K-Means Clustering dalam permasalahan klasterisasi dokumen.

TUJUAN

10 Juli 2013 Tugas Akhir - KI091391 8

TAHAPAN PRESENTASI

Gambaran umum sistemPendahuluan

Sistem Klasterisasi Dokumen

Uji Coba

Kesimpulan dan Saran

Alur Sistem Klasterisasi Dokumen

Tahap Pra Proses

K-Dimensional Tree

KD-Tree K-Means Clustering

26 Juli 2013 Tugas Akhir – KI091391 9

GAMBARAN UMUM SISTEM

Data set Kumpulan Dokumen / Artikel

Dokumen-dokumen yang telah diklasterisasi

Tahap Pra-Proses Dokumen

26 Juli 2013 Tugas Akhir – KI091391 10

ALUR SISTEM KLASTERISASI DOKUMEN

Data set Kumpulan Dokumen / Artikel

Data set denganformat bag of word

Input data set &Term Weighting

Proses KlasterisasiDokumen

Dokumen-dokumen yang telah diklasterisasi

26 Juli 2013 Tugas Akhir – KI091391 11

Penghapusanstop word

Data set KumpulanDokumen / Artikel Data set dengan

format bag of word

Tahap Pra – Proses Dokumen

ProsesStemmming kata

Proses seleksikata typo

Menghapus kata yang merupakan stop word dalamBahasa Inggris

Menyederhanakan kata kedalamBentuk stem

Hapus kata yang hanya munculPada satu dokumenHasil data set bag of word

Bertujuan untuk memberikan bobot penilaian pada setiap katayang menjadi fitur

Menggunakan perhitungan Term Frequency – InverseDocument Frequency (TF-IDF)

Proses pembobotan kata (term weighting)

26 Juli 2013 Tugas Akhir – KI091391 12

Proses pembobotan kata (term weighting)

26 Juli 2013 Tugas Akhir – KI091391 13

Data set sebelum term weighting

Data set setelah term weighting

Data struktur yang bersifat space-partitioning dan merupakankasus spesial dari binary space partitioning tree

Setiap node non-leaf pada KD-Tree merupakan garis yangmemisakan sebuah ruang menjadi 2 bagian

Menggunakan nilai median atau mean sebagai nilai pivot

K-Dimensional Tree

26 Juli 2013 Tugas Akhir – KI091391 14

K-Dimensional Tree

26 Juli 2013 Tugas Akhir – KI091391 15

Pemilihan atributpemisah/pivot

Penentuan nilaipemisah/pivot value

Pembuatanchild subtree

kiri dan kanan

Proses rekursifpada subtree child

subtreeadalah

leaf

Fungsi selesai

ya

tidak

Proses pemilihan atributpemisah:

Umumnya ditentukanberdasarkan kedalaman darinode saat iniaxis = depth mod k atauaxis = longest dimension

Pivot Value dapat menggunakanNilai median atau mean dariNilai-nilai pada atribut pemisah

Nilai median lebih seringdigunakan karena menghasilkantree lebih balance dibandingkannilai mean

Child subtree sebelah kiri akanmemiliki data dengan nilaiatribut < pivot value. SedangkanChild subtree sebelah kananakan memiliki data dengan nilaiatribut > pivot value

node.leftChild := kdtree(points < pivot value, depth+1);node.rightChild := kdtree(points > pivot value, depth+1);

Jika subtree telah memenuhikriteria leaf (kedalaman tertentu/ jumlah data maksimal)Maka fungsi rekursif selesai

Jika tidak, maka lanjutkanproses rekursif ke child subtree

K-Dimensional Tree

26 Juli 2013 Tugas Akhir – KI091391 16

Contoh hasil partisi K-Dimensional Tree pada data set 2 dimensi

Metode K-Means Clustering dengan perbaikan pada prosesinisialisasi titik tengah klaster

Menggunakan struktur data K-Dimensional Tree dannilai/ranking kerapatan dari leaf bucket untuk memilih posisiawal titik tengah

Nilai kerapatan 푝 = (푁 : Banyak poin pada leaf bucket, 푉 :

Volume area leaf bucket). nilai volume Vj : hasil perkalian darisemua rentang dimensi pada leaf bucket. Dimensi dengan nilairentang nol akan digantikan dengan nilai geometric mean darinilai rentang dimensi yang tidak bernilai nol.

Leaf bucket yang dipilih sebagai titik tengah adalah leaf bucketyang memiliki jarak terjauh dari titik tengah dan nilai kerapatantertinggi

KD-Tree K-Means Clustering

26 Juli 2013 Tugas Akhir – KI091391 17

KD-Tree K-Means Clustering

26 Juli 2013 Tugas Akhir – KI091391 18

Pembentukan strukturdata KD-Tree dari data

set

Perhitungan nilaikerapatan dari

setiap leaf bucket

Proses pemilihantitik tengah

dari leaf bucket

Penghapusan 20%Leaf bucket dengan

nilai kerapatanterendah

dan proses diulang

Jumlahtitik tengah =

Jumlahklaster

ya

tidak

K-Means Clustering dengan hasil inisialisasi

titik tengah

Pembentukan K-Dimensional Tree dari data set. K-Dimensional Tree yang dibuat akan memiliki leaf bucket dengan jumlah data maksimal20 per leaf bucket.

Untuk setiap leaf bucket(L1,L2,…,Lj) , kalkulasi nilai kerapatan(Pj) dari setiap leaf bucket Lj, dan kalkulasi nilai titik tengah leaf bucket(Mj) dengan mencari nilai rerata dari semua point yang ada pada leaf bucket Lj.

푃 = 푁푉

• Untuk t = 1, pilih titik tengahklaster pertama C1 = Mz, dimana 푧 = arg max 푃 .

• Untuk t = 2,…,K:Untuk j = 1,...,q kalkulasi nilai ranking leaf bucket (Gj) dengan fomula 퐺 = 푚푖푛

푘 = 1 … 푡 푑 퐶 ,푀 × 푃

Pilih titik tengah klaster Ct = Mz, dimana 푧 = arg max 퐺 .

Jalankan algoritma K-Means Clustering dengan nilai inisialisasi titik tengah (C1,...,Ck)dan (ĉ1, ĉ2,…, ĉk).

Hapus 20% leaf bucket dengan nilai kerapatan terendah, ulangiproses dan kalkulasi posisi Ktitik tengah klaster baru (ĉ1, ĉ2,…, ĉk).

Nilai 푃 dapat diganti dengan ranking density (푃 ). Leaf Bucketdengan nilai terendah memiliki nilai 푃 = 1 dan leaf bucketdengan nilai tertinggi memiliki nilai 푃 = n. Tujuan daripenggunaan ranking density adalah untuk mencegah nilaikerapatan yang terlalu dominan dibandingkan dengan jarak leafbucket ke titik tengah

Tujuan dari menghapus 20% leaf bucket terendah adalah untukmencegah leaf bucket yang merupakan outlier menjadi titiktengah

KD-Tree K-Means Clustering

26 Juli 2013 Tugas Akhir – KI091391 19

Leaf BucketDensity : 17,35

Leaf BucketDensity : 18,00

Leaf BucketDensity : 18,04

Leaf BucketDensity : 18,22Leaf BucketDensity Rank : 4

Leaf BucketDensity : 18,409

Leaf BucketDensity Rank : 1

Leaf BucketDensity Rank : 2

Leaf BucketDensity Rank : 3

Leaf BucketDensity Rank : 5

KD-Tree K-Means Clustering

26 Juli 2013 Tugas Akhir – KI091391 20

Centroid 1

Distance : 193,28

Distance : 9,635

Distance : 9,635

Distance : 145,195

Centroid 2

Distance : 200,915

Distance : 200,915

Distance : 139,92

min Distance : 9,635

min Distance : 9,635

min Distance :139,92

Centroid 3

10 Juli 2013 Tugas Akhir - KI091391 21

TAHAPAN PRESENTASI

Skenario Uji CobaPendahuluan

Sistem Klasterisasi Dokumen

Uji Coba

Kesimpulan dan Saran

Evaluasi Performa

Parameter Uji Coba

Hasil Skenario Uji Coba 1

Hasil Skenario Uji Coba 2

Skenario 1 : Uji coba implementasi KD-Tree K-Means Clusteringpada klasterisasi non dokumen menggunakan data set ImageSegmentation dan Pen-Based Recognition of HandwrittenDigits.

Skenario 2 : Uji coba perbandingan hasil klasterisasi dokumenKD-Tree K-Means Clustering dan K-Means Clustering pada dataset dokumen 20 newsgroup.

Uji coba dilakukan dengan membandingkan performa hasil KD-Tree K-Means Clustering dengan 15 kali proses K-MeansClustering.

SKENARIO UJI COBA

26 Juli 2013 Tugas Akhir – KI091391 22

EVALUASI PERFORMA (1)

26 Juli 2013 Tugas Akhir – KI091391 23

D = nilai distorsi data setn = jumlah data pada data setK = jumlah klaster hasil

Perhitungan menggunakan nilai distorsi euclidean distance (Nilai total kuadrat euclidean distance data ke titik tengah klaster)

Xi = data ke-i pada data setCj = klaster ke-jD(…,….) = Perhitungan jarak euclidean distance

Perhitungan menggunakan Normalized Information Gain

ENTOTAL : nilai Total Entropy atau rerata informasi yang ada di setiap data pada data set

EVALUASI PERFORMA (2)

26 Juli 2013 Tugas Akhir – KI091391 24

퐸푁 = −푐푛 푙표푔

푐푛 푏푖푡푠

L = Jumlah label pada kelas data setcl = Jumlah data yang memiliki label l

pada data set

EVALUASI PERFORMA (3)

26 Juli 2013 Tugas Akhir – KI091391 25

wEN: Rerata informasi data pada setiap klaster, memberikan nilai 0 pada saat semua klaster homogen

Enk : Nilai entropy dari sebuah klaster

K =Jumlah klasternk = Jumlah data pada klaster kn = Jumlah data pada data set

K =Jumlah label pada kelas data set

nk = Jumlah data pada klaster kcl

k = Jumlah data yang memilikilabel l pada klaster k

PARAMETER UJI COBA (1)

26 Juli 2013 Tugas Akhir – KI091391 26

Nama Parameter

Deskripsi

K Jumlah klaster pada proses klasterisasi m Jumlah fitur pada data set row Jumlah data pada data set Dkd Nilai distorsi dari proses klasterisasi dokumen

menggunakan algoritma KD-Tree K-Means Clustering Dminfa Nilai distorsi minimum dari 15 kali proses klasterisasi

dokumen menggunakan algoritma K-Means Clustering μfa Nilai rerata distorsi dari 15 kali proses klasterisasi

dokumen menggunakan algoritma K-Means Clustering σfa Standar deviasi distorsi dari 15 kali proses klasterisasi

dokumen menggunakan algoritma K-Means Clustering Nfa>kd Jumlah proses klasterisasi dokumen dari 15 kali iterasi

menggunakan algoritma K-Means Clustering yang memiliki nilai distorsi lebih baik daripada KD-Tree K-Means Clustering

PARAMETER UJI COBA (2)

26 Juli 2013 Tugas Akhir – KI091391 27

Nama Parameter

Deskripsi

Nfa=kd Jumlah proses klasterisasi dokumen dari 15 kali iterasi menggunakan algoritma K-Means Clustering yang memiliki nilai distorsi sama dengan KD-Tree K-Means Clustering

Nfa <kd Jumlah proses klasterisasi dokumen dari 15 kali iterasi menggunakan algoritma K-Means Clustering yang memiliki nilai distorsi lebih buruk daripada KD-Tree K-Means Clustering

NIGkd Nilai NIG dari proses klasterisasi dokumen menggunakan algoritma KD-Tree K-Means Clustering

NIGfa Nilai NIG maksimum dari 15 kali proses klasterisasi dokumen menggunakan algoritma K-Means Clustering

Tkd Waktu eksekusi dari proses klasterisasi dokumen menggunakan algoritma KD-Tree K-Means Clustering

Tminfa Waktu eksekusi minimum dari 15 kali proses klasterisasi dokumen menggunakan algoritma K-Means Clustering

Tmaxfa Waktu eksekusi maksimum dari 15 kali proses klasterisasi dokumen menggunakan algoritma K-Means Clustering

Ttotalfa Waktu eksekusi total dari 15 kali proses klasterisasi dokumen menggunakan algoritma K-Means Clustering

Hasil Uji Coba Skenario 1

2826 Juli 2013 Tugas Akhir – KI091391

SKENARIO 1 : UJI KINERJA KLASTERISASI NON-DOKUMEN KD-TREE K-MEANS CLUSTERING

Hasil KD-Tree K-Means Clustering memilikinilai NIG 0,06 lebih buruk dibandingkan nilaiNIG maksimum K-Means Clustering. Tetapimenghasilkan hasil distorsi sama dengan nilaiminimum distorsi dan lebih baik 6 × 105

dibandingkan dengan rerata nilai distorsi K-Means Clustering.

Selain itu dari 15 proses K-Means Clustering hanya 4 proses saja yang memiliki nilai distorsilebih baik dibandingkan hasil dari KD-Tree K-Means Clustering.

Parameter Image Segmentation

K 7 m 19 row 2310 Dkd 1,40 × 107

Dminfa 1,40 × 107 μfa 1,46 × 107 σfa 1,82 × 106

Nfa>kd 4 Nfa=kd 0 Nfa <kd 11 NIGkd 0,49 NIGfa 0,55

Tkd 3876 Tminfa 2884 Tmaxfa 11535 Ttotalfa 84645

Hasil Uji Coba Skenario 1

2926 Juli 2013 Tugas Akhir – KI091391

SKENARIO 1 : UJI KINERJA KLASTERISASI NON-DOKUMEN KD-TREE K-MEANS CLUSTERING

Hasil KD-Tree K-Means Clustering memilikinilai NIG 0,02 lebih buruk dibandingkan nilaiNIG maksimum K-Means Clustering. Tetapimenghasilkan hasil distorsi lebih baik 1,7 × 106

dibandingkan dengan rerata nilai distorsi K-Means Clustering.

Selain itu dari 15 proses K-Means Clustering hanya 2 proses saja yang memiliki nilai distorsilebih baik dibandingkan hasil dari KD-Tree K-Means Clustering.

Parameter Pen-based Recognition Handwritten Digits

K 10 m 16 row 10992 Dkd 5,01 × 107 Dminfa 5,00 × 107

μfa 5,17 × 107

σfa 1,27 × 106

Nfa>kd 2 Nfa=kd 0 Nfa <kd 13 NIGkd 0,67 NIGfa 0,69 Tkd 33497 Tminfa 20449 Tmaxfa 134524 Ttotalfa 675462

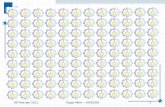

Hasil Uji Coba Skenario 2SKENARIO 2 : UJI PERFORMA KD-TREE K-MEANS CLUSTERING PADA DATA SET DOKUMEN

Hasil uji coba menunjukkan bahwa hasilklasterisasi dokumen menggunakan KD-Tree K-Means Clustering memiliki nilaidistorsi lebih buruk 2 × 105 dibandingkannilai distorsi minimum hasil K-Means Clustering. Namun Hasil ini lebih baik 3 × 105 dibandingkan dengan nilai reratadistorsi dari K-Means Clustering.

Pada perhitungan nilai NIG, hasil dariKD-Tree K-Means Clustering memilikinilai NIG 0,18. Hasil ini lebih baik 0,09 dibandingkan dengan nilai NIG maksimum yang didapatkan oleh K-Means Clustering.

Parameter Nilai K 20 m 20536 Dkd 4,14 x 107

Dminfa 4,12 x 107

μfa 4,17 x 107 σfa 3,00 x 105

Nfa>kd 4 Nfa <kd 11 NIGkd 0,18 NIGfa 0,09 Tkd 13295630 Tminfa 2535463 Tmaxfa 12619237 Ttotalfa 105325216

08 Juli 2013 Tugas Akhir - KI091391 31

TAHAPAN PRESENTASI

Pendahuluan

Sistem Klasterisasi Dokumen

Uji Coba

Kesimpulan dan Saran

1. Performa klasterisasi yang dihasilkan oleh metode KD-Tree K-Means Clustering pada data set non dokumen yaitu ImageSegmentation dan Pen-Based Recognition of Handwritten Digitsmemiliki hasil distorsi yang lebih baik dibandingkan dengan nilairerata distorsi 15 kali proses K-Means Clustering. Selain itu,metode KD-Tree K-Means Clustering juga memiliki waktu eksekusiyang relatif sama dengan waktu eksekusi dari K-Means Clustering.

2. Performa yang dihasilkan oleh metode KD-Tree K-MeansClustering pada klasterisasi dokumen data set 20 newsgroupmemiliki nilai distorsi 3 × 105 lebih rendah dibandingkan dengannilai rerata distorsi dari K-Means Clustering. Selain itu nilai NIGKD-Tree K-Means Clustering 0,09 lebih baik dibandingkan nilaiNIG maksimum K-Means Clustering.

KESIMPULAN

26 Juli 2013 Tugas Akhir – KI091391 32

1. Performa dari KD-Tree K-Means Clustering untuk klasterisasidokumen dapat ditingkatkan salah satunya dengan melakukanproses seleksi fitur. Akan tetapi pemilihan metode seleksi fiturharus dilakukan secara hati-hati sesuai dengan karakteristikdan problem dari klasterisasi teks yang berdimensi tinggi.

2. Perbaikan lain yang bisa dilakukan adalah dengan memperbaikiefisiensi running time dari KD-Tree K-Means Clustering karenaKD-Tree K-Means Clustering membutuhkan waktu trainingyang lama pada klasterisasi data set berdimensi tinggi sepertidata set dokumen.

SARAN

26 Juli 2013 Tugas Akhir – KI091391 33