Die geistigen und technischen Wurzeln des Personal Computers

Click here to load reader

-

Upload

independent -

Category

Documents

-

view

1 -

download

0

Transcript of Die geistigen und technischen Wurzeln des Personal Computers

Was bringt historische Forschung für aktuelle Wis-senschafts- und Technikgestaltung? Allzu oftwurde diese Frage mit der naiven Vorstellung

beantwortet, aus den Ergebnissen historischer Forschungkönne man Konsequenzen für aktuelles Handeln ableiten.Unter Historikern wird die Funktionalisierung histori-scher Betrachtungen für aktuelle Diskussionen überwie-gend abgelehnt. Sie wollen aus ihren Forschungsergebnis-sen keine Prognosen für die Zukunft ableiten, sondern denBlick für aktuelle Betrachtungen schärfen. Lernen kannman aus der Geschichte vor allem, wie komplex soziale,kulturelle und damit auch technische und wissenschaftli-che Entwicklungen sind und dass man sich daher vorschnellen Urteilen und Kausalitätsbehauptungen hütenmuss. Deshalb geht es dem Technikhistoriker darum, ausder Distanz der historischen Rekonstruktion differenziertePerspektiven auch auf die heutige Informatik zu ermögli-chen.

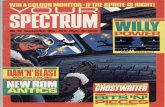

Wenn heute vom Computer gesprochen wird, ist meistder kleine Personal Computer mit Tastatur, Bildschirmund Maus gemeint, der seit 1981 den Weg in MillionenBüros und Haushalte gefunden hat und meist zur Textver-arbeitung, für Kalkulationen, zum Spielen und zuneh-mend auch als Kommunikationsmedium verwendet wird.Davor war ein anderes Bild des Computers in der Öffent-lichkeit vorherrschend. Computer waren riesige Geräte,mit deren Betrieb ein ganzes Team von Technikern, Ope-rateuren und Programmierern beschäftigt war. Sie warenso groß und teuer, dass sich nur große Unternehmen,Behörden und das Militär Computer leisten konnten, umdamit komplizierte Berechnungen anzustellen oder großeDatenmengen zu verwalten. Diese Maschinen spielen zwarheute in diesem Umfeld immer noch eine wichtige Rolle,

sind aber fast aus dem Blick der Öffentlichkeit verschwun-den.

Nach weit verbreiteter Vorstellung beginnt dieGeschichte des PCs mit der Erfindung des Mikroprozes-sors durch Intel im Jahre 1971. Als nächste Etappen gel-ten die ersten Computerbausätze, die erfolgreichen Home-computer der späten siebziger Jahre, die Einführung desIBM PC 1981 und schließlich die Einführung des derzeitigleistungsfähigsten Rechner mit Pentium III Prozessor.Demnach wären Personal Computer das zwangsläufigeEndprodukt der fortschreitenden Miniaturisierung in derMikroelektronik.

Eine andere, weniger verbreitete, aber ebenso populäreGeschichte des PCs erzählt von begeisterten Computera-mateuren in Kalifornien, die es geschafft haben, gegen dieInteressen der großen Unternehmen den Computer zu denMenschen bringen. "Computer Power to the People” laute-te einer ihrer Wahlsprüche, der von den politischen Ideender 68er-Generation beeinflusst war [1].

Diese Sichtweisen sind nicht falsch. Sie übersehenallerdings die Kontinuität, die es beim Übergang vomgemeinsam genutzten Großcomputer zum einzeln verwen-deten Personal Computer gegeben hat. Und sie lassenaußer Acht, dass die Idee für eine persönliche, Daten ver-arbeitende Maschine wesentlich älter ist, sogar älter alsder Digitalcomputer selbst. Wenig Beachtung fand bislangdie Frage, vor welchem kulturellen Hintergrund die Ideeder persönlichen Informationsverarbeitungsmaschine ent-standen ist und wie sich diese im Laufe der Zeit unter demEinfluss anderer Wissenschafts- und Technikentwicklun-gen verändert hat. Im Folgenden sei daher an einigenrepräsentativen Beispielen nachgezeichnet, wie bestimmteIdeen zu Leitbildern der Technikentwicklung geworden

Naturwissenschaftliche Rundschau | 53. Jahrgang, Heft 4, 2000

165

Personal Computer sind aus der heutigen Arbeitswelt nicht wegzudenken und haben längstihren festen Platz als privates Kommunikationsmedium. Die historische Analyse zeigt, dass dieEnt-wicklung des interaktiven Computers von 1945 bis 1985 nicht zielgerichtet erfolgte. Der heu-tige Stand der Technik ist vielmehr Schlusspunkt einer eher zufälligen Folge lokaler Gegebenhei-ten und Umstände. Technische Neuerungen, wie der Digitalcomputer und die Mikrochips, aberauch theoretische Konzepte (Kybernetik, Kognitive Psychologie) und Visionen trieben die Ent-wicklung voran. Entscheidend für den Durchbruch war das Zusammentreffen akademischer undanwendungsorientierter Forschung.

Die geistigen und technischen Wurzelndes Personal Computers

Michael Friedewald, Karlsruhe

ÜBERSICHT

sind, wie sich diese Leitbilder durch die Kommunikationzwischen den Mitgliedern einer überschaubaren Gruppevon Wissenschaftlern verbreitet haben und wie sich dieIdeen mit der jeweils verfügbaren Technik, mit den wech-selnden Finanzierungsquellen der Forschung und nichtzuletzt mit den veränderten politischen und gesellschaftli-chen Bedingungen gewandelt haben.

Kybernetik und DigitalcomputerEine "Ideengeschichte” des Personal Computers muss

weit ausholen. Drei wichtige Entwicklungen der vierzigerJahre verdienen besondere Beachtung:

Die erste ist die Entwicklung des elektronischen Digital-computers am Ende des Zweiten Weltkrieges. Über diePionierarbeiten von Presper Eckert und John Mauchly ander Moore School of Electrical Engineering in Philadelphiaund von John von Neumann am Institute for AdvancedStudy in Princeton sind bereits mehrere Studien vorgelegtworden [2, 3]. Interessanter für die Geschichte des Perso-nal Computers sind die zwei anderen Entwicklungen.

Im August 1945 entwarf der bekannte Analogrechner-pionier und Wissenschaftspolitiker Vannevar Bush(1890–1974) in seinem Aufsatz "As we may think” die Visi-on des Memory-Extender (Abb. 1). Er beschrieb detailliert,wie Wissenschaftler mit dieser informationsverarbeiten-den Maschine arbeiten und in Interaktion treten könnten.

Aufgabe einer solchen Maschine sollte es sein, den Wis-senschaftler bei der Verwaltung der täglich anfallendenDaten zu helfen, indem sie beispielsweise Zeitschriftenauf-sätze, Messergebnisse, handschriftliche Notizen und Foto-graphien speichert. Die Information sollte nach biologi-schem Vorbild assoziativ miteinander verbunden sein.Schließlich sollte der Benutzer in der Lage sein, mit demGerät zu arbeiten, ohne sich über die Realisierung Gedan-ken machen zu müssen (Abb. 2) [4].

Der Memory Extender wurde zwar nie in der von Bushbeschriebenen Form realisiert, hatte aber eine inspirieren-

de Wirkung auf eine ganze Reihe von jungen Wissen-schaftlern. Sie begannen in den fünfziger und sechzigerJahren Aspekte des Memex in den Entwurf von neuenComputersystemen zu übernehmen.

Die dritte wichtige Entwicklung war die Etablierungder Kybernetik als wissenschaftliche Disziplin. Mit ihrsetzte sich nämlich die Erkenntnis durch, dass der Menschin komplexen technischen Systemen eine wichtige Rollespielt. Das bis dahin vorherrschende lineare Modell derDatenverarbeitung (Eingabe von Daten

→ Verarbeitungder Daten → Ausgabe der Ergebnisse – alles ohne Eingriffdes Menschen) wurde zu einem geschlossenen Regelkreiserweitert, in dem der Mensch nicht nur ein Anhängsel derMaschine war. Es entstand das "Human Factors Enginee-ring”, das den Menschen mit seinen physischen und kogni-tiven Fähigkeiten und Limitierungen beim Entwurf tech-nischer Systeme berücksichtigte.

Ein Beispiel für diesen Trend ist die Computerentwick-lung am Bostoner Massachusetts Institute of Technology(MIT) zwischen 1945 und 1960. Die dort tätigen Ingenieu-re waren, anders als die meisten anderen Computerkon-strukteure, durch die Regelungstechnik beziehungsweiseKybernetik geprägt. Sie entwickelten in den fünfziger Jah-ren ein erstes computergestütztes Luftverteidigungssy-stem, für das nicht nur einer der leistungsfähigsten Digi-talrechner der damaligen Zeit entwickelt wurde, sondernauch eine erste auf wissenschaftlichen Erkenntnissenbasierende Mensch-Computer-Schnittstelle oder Interface(Abb. 3). Dabei musste berücksichtigt werden, dass dasBedienpersonal nicht aus Computerspezialisten, sondernaus einfachen Soldaten bestand. Zu diesem Zweck wurdenerstmals Verfahren zur Ein- und Ausgabe von Daten inunmittelbarer Interaktion mit dem Computer entwickelt,die den hohen militärischen Anforderungen entsprachen.Dabei entstanden Bildschirmsysteme für Texte und Grafi-ken sowie der Lichtgriffel als Eingabegerät für grafischeDaten [5].

Übersicht

Naturwissenschaftliche Rundschau | 53. Jahrgang, Heft 4, 2000166

Abb.1.

Der Computerpionier VannevarBush entwarf 1945 die Vision eines"Memory Extender" (Memex). Diese Denk-maschine stellte er sich nicht wie einentypischen Großcomputer der Zeit vor, son-dern als einen Schreibtisch mit zwei Pro-jektionsbildschirmen. Die Speicherung derDaten sollte über ein im Schreibtisch ein-gebautes Mikrofilmgerät (links, unterSchreibtischplatte) erfolgen. Ein solcherMemex gehörte nach Bushs Einschätzungzukünftig in das Arbeitszimmer jedes Wis-senschaftlers. Zeichnung von Alfred D.Crimi (1945). Aus [19]

Mensch-Computer-SymbioseDie Realität der Computernutzung sah in den fünfziger

Jahren aber fast immer anders aus als bei diesen wenigenmilitärischen Computersystemen. Computer, wie sie inWirtschaft, Staat und Universitäten verwendet wurden,waren keine Geräte, an denen man unmittelbar arbeitenkonnte. Und weil die Computer teuer waren, mussten siemöglichst rund um die Uhr in Betrieb sein - das Resultatdieser wirtschaftlichen Überlegung war die so genannteStapelverarbeitung. Diese Betriebsweise machte dasArbeiten mit dem Computer besonders für die Program-mierer nicht leicht: Sie mussten ihr Programm zunächstauf Papier schreiben, dann wurde es auf Lochkartengestanzt. Der Stapel mit Lochkarten - daher der Name -wurde dem Operateur im Rechenzentrum übergeben. Dortwurden die Daten dann auf ein Magnetband übertragen.Das Band wurde schließlich in den Computer eingelesen,und die Resultate der Verarbeitung auf ein weiteres Bandgespeichert oder über einen Zeilendrucker ausgegeben. Beider Stapelverarbeitung dauerte es deshalb immer mehrereStunden, bis der Programmierer sehen konnte, ob seinProgramm wirklich das tat, was es tun sollte. Insbesonde-re die Verbesserung von Programmierfehlern war aufdiese Weise extrem mühsam.

Aus Unzufriedenheit mit dieser Situation wurde seitBeginn der Sechziger Jahre der Versuch unternommen,den Benutzer, insbesondere den Programmierer, wieder inengeren Kontakt mit dem Computer zu bringen. J. C. R.Licklider (1915–1990), Professor für experimentelle Psy-chologie und Elektronik am MIT, griff dazu Ansätze ausder frühen Künstlichen-Intelligenz-Forschung auf undentwickelte daraus die Idee der Mensch-Computer-Sym-biose. Nach seiner Vorstellung sollte der Computer denBenutzer bei allen routinemäßig anfallenden Tätigkeitenunterstützen, beim Schreiben von Programmen und Tex-ten ebenso wie beim Erstellen von Grafiken aus Messrei-hen. Voraussetzung hierfür war jedoch, dass die Benutzerin unmittelbarer Interaktion mit dem Computer arbeitenkonnten. Ideal wäre es, so Licklider, wenn jeder Benutzereinen eigenen Computer zur Verfügung hätte [6].

Dafür war die Zeit um 1960 noch nicht reif, denn Com-puter waren immer noch groß und sehr teuer. Die Zentral-einheiten von Computeranlagen waren aber schon so lei-stungsfähig, dass die Eingaben des Benutzers bereits vielmehr Zeit benötigten als die eigentliche Verarbeitung.Man konnte deshalb beim so genannten "Time-Sharing”die Rechenzeit auf viele gleichzeitig am Rechner Arbeiten-de aufteilen, ohne dass merkliche Verzögerungen eintra-ten. Obwohl der Computer weiterhin von einer Vielzahlvon Personen gleichzeitig benutzt wurde, hatte jeder denEindruck, er habe den ganzen Rechner zur alleinigen Ver-fügung [7].

Als Licklider 1962 einen wichtigen Posten bei dermilitärischen Advanced Research Projects Agency (ARPA)übernahm, konnte er durch großzügige Fördergelder dieRealisierung seiner Idee in Form von Timesharing-Compu-tern forcieren [8]. Bei Timesharing-Computern ändertesich auch die Art der Programme. Während der Pro-grammablauf zuvor nicht unterbrochen werden konnte,wurde die Programmunterbrechung nun zum charakteri-stischen Merkmal. Interaktive Programme, bei denen derBenutzer während der Ausführung Eingaben machenkonnte, gaben diesem das Gefühl, mit dem Computer zukommunizieren und partnerschaftlich zusammenzuarbei-ten. Obwohl auch der Ablauf interaktiver Programme imVoraus festgelegt war, vermittelten sie ihren Benutzerndas scheinbare Gefühl der Kontrolle über die Maschine.Man erkannte bald, dass der Umfang dieser Illusion vonder Gestaltung der Mensch-Computer-Schnittstelleabhängt. Um "Missverständnisse” zwischen dem Compu-ter und seinem menschlichen Benutzer zu vermeiden,musste der Programmierer bereits im Vorfeld dafür sor-gen, dass er stets eine korrekte Vorstellung über dessenIntentionen besaß. Dass es nicht immer leicht ist, diese

Friedewald: Die geistigen und technischen Wurzeln des Personal Computers

Naturwissenschaftliche Rundschau | 53. Jahrgang, Heft 4, 2000 167

Abb. 2. Bildschirme des Memex mit der Möglichkeit zur handschriftli-chen Eingabe. Aus [19]

Abb. 3. Das erste computergestützte LuftüberwachungssystemSAGE (Semi-Automatic Ground Environment) wurde 1950 bis 1957vom MIT Lincoln Laboratory und IBM entwickelt. Die Überwachungs-aufgaben wurden von einfachen Soldaten an Bildschirmarbeitsplät-zen durchgeführt. Die Abfrage von Informationen über die angezeig-ten Flugzeuge und die Eingabe von neuen Daten erfolgte mit Hilfeeiner "Light Gun" unmittelbar am Birldschirm. [The Computer Muse-um History Center]

einfach klingende Anforderung zu erfüllen, ist auch heutenoch zu spüren.

ComputerwerkzeugeDie interaktive Benutzung eröffnete auch völlig neue

Anwendungsgebiete, bei denen die Vorstellung des Com-puters als individuelles Werkzeug in den Vordergrundtrat. Ein Textverarbeitungsprogramm stellt zum Beispieldie Funktionen zur Verfügung, die man zum Erstellen,Formatieren und Drucken eines Textes benötigt. Inhaltund äußere Form des Textes werden allerdings durch dieAktionen des Benutzers mit dem Programm festgelegt.Dadurch erhält der Benutzer des Computers eine relativhohe Autonomie gegenüber seinem Arbeitsmittel. Erbehält stets das bearbeitete Material im Auge, an dem dievorgenommenen Änderungen sofort sichtbar sind.

Als Beispiel für die Konsequenzen dieser verschobenenSichtweise können die Arbeiten von Douglas Engelbart(*1925) am Stanford Research Institute während der sech-ziger Jahre gelten. Engelbart machte sich Gedanken überein Gerät, mit dessen Hilfe man die geistige Arbeit vonWissenschaftlern und Managern effektiver gestalten konn-te, und sprach von der Verstärkung der menschlichenIntelligenz mithilfe des Computers. Zu diesem Zweck griffer bereits zu Beginn der sechziger Jahre Ideen der nochjungen kognitiven Psychologie auf und entwickelte auf die-ser Grundlage einen theoretischen Rahmen für die Gestal-tung der Mensch-Computer-Schnittstelle [9, 10]. Gleichzei-tig entwickelten Engelbart und seine Mitarbeiter lei-stungsfähige Werkzeuge für die Dokumentenerstellungund verwaltung sowie für Aufgaben des Projektmanage-ments. Bei Engelbarts 1968 öffentlich vorgestelltem inter-aktiven Computersystem wurde auch erstmals die bisheute übliche Form der Computerarbeit praktiziert: DerBenutzer arbeitete an einem Terminal mit einem alphanu-merischen oder Grafikmonitor, einer Tastatur und mit dervon Engelbart erfundenen "Maus” (Abb. 4) [11].

ComputermedienWährend in den sechziger Jahren vor allem Computer-

werkzeuge für die individuelle Unterstützung von Pro-grammierern und anderen Computerfachleuten im Vor-dergrund gestanden hatten, wurde in den siebziger Jahrenimmer stärker an Computersystemen gearbeitet, die überComputernetze miteinander verbunden waren und mitdenen auch Laien arbeiten können sollten.

Seit 1971 gab eine junge interdisziplinär interessierteGruppe von Wissenschaftlern am Palo Alto Research Cen-ter (PARC) von Xerox in beiden Bereichen entscheidendeImpulse. Unter der Leitung von Robert Taylor (*1932),einem erfahrenen Forschungsorganisator, entwickelte eineGruppe, der viele ehemalige Mitarbeiter Engelbartsangehörten, die Computerwerkzeuge für das so genannte"Büro der Zukunft”. Dabei entstanden nicht nur der ersteArbeitsplatzcomputer und ein erstes lokales Netzwerk, dasEthernet, sondern auch eine Vielzahl von Programmen zurUnterstützung der Arbeit von Wissenschaflern, Ingenieu-ren und Managern, darunter zukunftsweisende Textverar-beitungs- und Grafikprogramme, die später als Vorlagenfür die heute so erfolgreichen Office-Programme dienten.

Den Computerwissenschaftlern wurde bald klar, dassihre Vorstellung eines vollautomatisierten und papierlosenBüros allzu naiv gewesen war, da das Wissen über dieTätigkeiten in einem Büro nicht nur informell und intuitivist, sondern sich auch auf eine Vielzahl von Personen ver-teilt. Weil solches Wissen nur schwer formalisiert werdenkann, legten die PARC-Wissenschaftler besonderen Wertauf die Anpassung der Computersysteme an individuelleBedürfnisse, die einfache Bedienbarkeit und die Möglich-keiten zur computervermittelten Kommunikation [12].

Gleichzeitig arbeitete eine andere Gruppe unter Lei-tung von Alan Kay (*1940) an der ProgrammierspracheSmalltalk, die auch Computerlaien und sogar Kinder zuProgrammierern machen sollte (Abb. 6). Sie sollte denComputer zu einem universellen Medium für die Informa-tionsbedürfnisse für Jedermann machen, zu einem Spei-cher für Texte und Notizen mit dem man aber auch spie-len, Bilder zeichnen, Musik komponieren und abspielen

Übersicht

Naturwissenschaftliche Rundschau | 53. Jahrgang, Heft 4, 2000168

Abb. 4. Douglas C. Engelbart und William K. English entwickeltenAnfang der sechziger Jahre die erste Maus, um die Manipulation vonTexten am Bildschirm zu vereinfachen. Die Maus besteht aus einemausgehöhlten Holzblock und zwei sekrecht zueinander angeordnetenMetallrädern, die an veränderliche Widerstände angeschlossen sind.[SRI International]

Abb. 6. Douglas C. Engelbart präsentierte 1968 ein Computersy-stem, das mit Terminals ausgestattet war und den heutigen Compu-tern sehr ähnelt. Es bestand aus einem Fernsehmonitor, Einhand-und Schreibmaschinentastatur sowie der ersten in Kleinserie gefer-tigten Maus. Auf dem Bildschirm konnten Texte, Graphiken undsogar Videos fargestellt werden. Aus [11]

oder mit Freunden Botschaften austauschen konnte. Umdiesem Personenkreis den Zugang zum Computer weiterzu erleichtern, entstand unter Nutzung von Erkenntnissenaus der Entwicklungspsychologie auch die erste grafischeBenutzeroberfläche mit den heute so selbstverständlichenBestandteilen wie Fenstern, Icons und Bildschirmmenüs(Abb. 7) [13].

Im Gegensatz zu allen bislang geschilderten Vorgänger-projekten waren die Arbeiten bei Xerox keine reinen For-schungsarbeiten mehr. 1975 beschloss das Managementvon Xerox, einen Bürocomputer auf den Markt zu ent-wickeln, in den die Forschungsergebnisse des Palo AltoResearch Center und all seiner Vorgänger einfließen soll-ten. Dieser Rechner mit graphischer Benutzeroberflächeund Mausbedienung, mit Laserdrucker und der Anschlus-smöglichkeit an ein lokales Datennetz kam Anfang 1981auf den Markt – und wurde ein wirtschaftlicher Misser-folg.

Der Weg zum MassenartikelDer Grund für diesen Misserfolg war nicht nur der hohe

Preis von etwa 15 000 $, sondern auch die Tatsache, dassIBM 1981 ebenfalls einen Personal Computer auf denMarkt brachte, der zwar längst nicht so leistungsfähig warwie das Gerät von Xerox, dafür aber vom Marktführer beiGroßcomputern hergestellt wurde und einen deutlichgeringeren Preis hatte. Hier trifft sich nun die kurz skiz-zierte Geschichte des interaktiven Computers mit derbekannten Geschichte des Mikroprozessors und der Mikro-computer.

Fast hätten sich diese beiden Entwicklungssträngenicht getroffen. In der Computerindustrie gab es in densiebziger Jahren immer noch den Trend zu immer höherenLeistungen und eine fortbestehende Dominanz der Stapel-verarbeitung. Die akademische Welt – zu der auch dasForschungszentrum von Xerox zu zählen ist – führte inihrem Elfenbeinturm weitgehend selbstverliebte Projekte

durch, die oft wenig mit den Bedürfnissen potentiellerKunden zu tun hatten. Und die Halbleiterindustrie hattezunächst keine Idee, welches wirtschaftliche Potential derMikroprozessor besaß. Anfangs sah es so aus, als gebe esfür die noch leistungsschwachen Mikroprozessoren keineernst zu nehmenden Anwendungen. Hier waren es danntatsächlich die Computeramateure oder Hacker, wie sichselbst nannten, die neue Einsatzbereiche definierten undbinnen weniger Jahre eine neuen Sektor der Computerin-dustrie aufbauten. Junge und risikobereite Unternehmenwie Apple oder Microsoft, die an den wirtschaftlichenErfolg von preiswerten Computern für jedermann glaub-ten, machten der Personal Computer Anfang der achzigerJahre zu einem erfolgreichen Produkt [14]. Sie waren esschließlich auch, die benutzerfreundliche und (bis zueinem gewissen Grade, s. u.) intuitiv zu bedienende Com-puter mit grafischen Benutzeroberflächen zu einem Kon-sumgut gemacht haben, das heute jedes Jahr millionen-fach verkauft wird. Wenn sie fähig waren, weiter zu sehenals andere, dann deshalb, weil sie auf den Schultern vonRiesen standen und auf die Erfahrungen aus über dreißigJahren Forschung zurückgreifen konnten.

Ende der Entwicklung?Mitte der achtziger Jahre hatten sich Personal Compu-

ter wie der IBM PC und der Apple Macintosh etabliert.

Friedewald: Die geistigen und technischen Wurzeln des Personal Computers

Naturwissenschaftliche Rundschau | 53. Jahrgang, Heft 4, 2000 169

Abb. 6. Alan C. Kay beschrieb Anfang der siebziger Jahre seine Vor-stellung vom zukünftigen Computer. Sein "Dynabook" war so kleinund leicht, dass man es überall hin mitnehmen konnte. Es war kin-derleicht zu bedienen und konnte nicht nur zum Erstellen und Spei-chern von Texten, Bildern und Musik verwendet werden, sondernauch zum Kommunizieren und zum Spielen. [Alan Kay]

Abb. 7. Der Xerox Alto war Mitte der siebziger Jahre eine der erstenArbeitsplatzrechner. Er war mit einem Grafikbildschirm, einer großenWechselplatte ausgestattet. Fuer den Alto wurde eine Reihe vonwichtigen Pionierprogrammen entworfen: Ein Texteditor (aus demschließlich Microsoft Word hervorging), Grafikprogramme und dieProgrammiersprache Smalltalk, für die die ersten grafische Benutzer-oberfläche entwickelt wurde. [Xerox Palo Alto Research Center]

Computer sind seitdem keine Rechenmaschinen mehr,sondern vor allem Arbeits- und Spielgeräte, seit Beginnder neunziger Jahre zunehmend auch Kommunikations-und Informationsmedien. Seit dem Beginn dieser Ära sind15 Jahre vergangen. Mittlerweile gibt es kaum mehr Com-putersysteme, die nicht über eine grafische Benutzerober-fläche zu bedienen sind. Dabei fällt auf, dass bei derGestaltung der Mensch-Computer-Schnittstelle seit Endeder achtziger Jahre kaum neue Ideen erkennbar sind.Vielmehr sind die Produkte der großen Hersteller heutekaum mehr voneinander zu unterscheiden. Es bleibt zudiskutieren, ob man mit dem Defacto-Standard ein Opti-mum an Benutzerfreundlichkeit oder sogar eine ersteStufe der Mensch-Computer-Symbiose erreicht hat, oderob die eigentliche Computerrevolution noch bevorsteht.Nach der Ansicht von Alan Kay haben die heutigen Benut-zeroberflächen (mit Fenstern, Icons, Menüs) mit ihremSchwerpunkt auf der direkten Manipulation von Bildschir-mobjekten die Möglichkeiten des Computers lediglichangerissen. Tatsächlich sind heutige grafische Benutzer-oberflächen nicht viel benutzerfreundlicher als bei denersten Personal Computern. Schon damals zeigten Tester-gebnisse, dass eine Benutzeroberfläche, die mit Metaphernarbeitete, eine Abstraktion ist, die mit den realen Fähig-keiten vieler Benutzer nicht viel zu tun hatte. Mittlerweilehaben sich die meisten Computerbenutzer so an dieBenutzungsschnittstellen ihres Computers gewöhnt, dasssie diese Gewöhnung mit der Benutzerfreundlichkeit desComputers verwechseln. Tatsächlich kann man aberimmer wieder beobachten, dass die scheinbar einfacheBenutzeroberfläche die Benutzer davon abhält, überhaupt

Bedienungsanleitungen und Handbücher zu lesen, weilsich Grundelemente des Programms bequemer durch Aus-probieren erlernen lassen. Dies führt dazu, dass ein großerTeil der Funktionalität verborgen bleibt und die Fähigkei-ten des Programms falsch eingeschätzt werden [15].

Deshalb darf man mit einiger Berechtigung behaupten,dass die Metapher des Schreibtisches wegen ihres Erfolgsheute zu einem Hemmnis bei der Entwicklung von nochbenutzerfreundlicheren Computern geworden ist. Bereits1984 formulierte Alan Kay diese Tendenz in einem Auf-satz für Scientific American:

"A powerful genre can serve as wings or chains. Themost treacherous metaphors are the ones that seem towork for a time, because they can keep more powerful insi-ghts from bubbling up. As a result progress is slow..." [16]

Die Metapher des Schreibtisches ist auch aus einemanderen Grund eher hinderlich: Die Zielgruppe, die dieHersteller von benutzerfreundlichen Computern anspre-chen wollten, waren ursprünglich die klassischen Informa-tionsarbeiter wie Wissenschaftler und Manager. Diese hat-ten in der Regel keine Erfahrungen im Umgang mit demComputer, waren aber mit der klassischen Büroumgebungvertraut. In der Zwischenzeit hat der Einsatz von Compu-tern die Büroarbeit weitgehend verändert, und viele derjüngeren Computernutzer haben bereits als Kinder Erfah-rungen mit Computern sammeln können. So wie sich dasAuto vom Vorbild der Kutsche lösen musste, um ein eige-nes Profil zu gewinnen, muss sich die Mensch-Computer-Schnittstelle von dem anfangs hilfreichen, nun aber eherhemmenden Vorbild des Schreibtisches befreien.

Bei einer Neudefinition der Mensch-Computer-Schnitt-stelle kann auch der Versuch unternommen werden, dieimmer noch divergierenden Nutzergruppen zusammenzu-führen. Dazu müßte dem Wunsch der "naiven Benutzer"nach leichter Erlernbarkeit und intuitiver Bedienung desComputers ebenso entsprochen werden wie dem Bedürfnisprofessioneller Benutzer nach umfassender Konfigurier-und Programmierbarkeit von Hard- und Software. Nur sokann wirklich sichergestellt werden, dass sich der durch-schnittliche Benutzer eines Computers, der irgendwo zwi-schen den beiden Extremen angesiedelt ist, weder bevor-mundet noch überfordert fühlt.

Es ist allerdings nicht ausreichend, besonders benutzer-freundliche und aufgabengerechte Computer und Benut-zungsschnittstellen zu entwickeln. Schon Mitte der achtzi-ger Jahren wurde festgestellt, dass die Computertechniknicht in erwartetem Maße zur Produktivitätssteigerung inUnternehmen beitragen konnte. Mittlerweile ist klar, dassdieses Produktivitätsparadoxon vielfach auf Anpassungs-probleme der Verwender zurückzuführen ist. Der Einsatzder Informationstechnik produziert keine materiellenGüter, sondern Informationen, die erst in einer angepas-sten Organisationsstruktur und durch ihre effiziente Ver-wendung einen eigenständigen Wert erlangen. Dennochwurden und werden die meisten Computeranwendungennach tayloristischem Vorbild gestaltet, das heißt sie beton-ten eine unflexible Arbeitsteilung. Außerdem wird bei derAuswahl eines Computersystems der Gesichtspunkt derSoftware-Ergonomie nur selten beachtet. In vielen Ent-scheidungsmodellen, die heute für die Systemwahl ange-

Übersicht

Naturwissenschaftliche Rundschau | 53. Jahrgang, Heft 4, 2000170

Abb. 8. Der Star war der erste von Xerox angebotene Arbeitsplatz-rechner. Wie der Xerox Alto war er mit einer grafischen Benutzer-oberfläche, der Möglichkeit zum Anschluß an ein lokales Netzwerkund einer Reihe von leistungsfähigen Office-Programmen ausgestat-tet. Wegen seines hohen Preises (15 000 $) wurde der Star nichtzum erhofften Erfolg. [Xerox Corporation]

wendet werden, wird die Benutzbarkeit und Benutzer-freundlichkeit nicht oder nur schwach berücksichtigt [17].

Auch auf gesamtgesellschaftlicher Ebene sind die heuti-gen Computer kein Allheilmittel für das immer noch aktu-elle Informationsproblem. Es scheint sogar, als habe dasexponentielle Anwachsen der verfügbaren Datenmenge imInternet mehr negative als positive Wirkungen. Die Hand-lung des bewussten Informierens degeneriert zunehmendzur Datensammlung. In den vergangenen Jahrzehntensind uns bei allem technischen Fortschritt die gesellschaft-lichen Institutionen verloren gegangen, die uns diesesBewusstsein vermitteln könnten. Bis in die sechzigerJahre wurde die Vorauswahl und Bewertung von Informa-tion durch kompetente Herausgeber oder Verlage vorge-nommen. Weil die individuellen und gesellschaftlichenMechanismen zum Umgang mit Information mit dergewandelten Situation heute immer mehr überfordertsind, spricht der umstrittene amerikanische Mediensozio-loge Neil Postman sogar von "kulturellem Aids”:

"Die Informationsschwemme führt auch zu einem wach-senden Gefühl der Ohnmacht. (...) Daraus, daß man tau-send Dinge kennt und weiß und nicht imstande ist, Ein-fluß auf sie zu nehmen, erwächst ein eigenartiger Egois-mus. Schlimmer: Die meisten Menschen glauben immernoch, Information und immer mehr Information sei das,was die Menschen vor allem benötigten. Die Informationbilde die Grundlage all unserer Bemühungen um dieLösung von Problemen. Aber die wirklich ernsten Proble-me der Menschheit erwachsen nicht daraus, daß die Men-schen über unzureichende Informationen verfügen. Wennes zu einer Nuklearkatastrophe kommt, dann nicht wegenunzureichender Information. Wo Menschen verhungern,geschieht das nicht wegen unzureichender Information ...,sondern weil wir kein zureichendes Bewußtsein davon ent-wickeln, was sinnvoll und bedeutsam ist." [18]

Diese Entwicklung konnte auch durch den Einsatz desComputers bislang nicht gestoppt werden. Heute sindgerade wegen der allgegenwärtigen Informations- undKommunikationstechnik mehr Informationen verfügbarals je zuvor in der Geschichte. Wenn man den Computertrotzdem als grundsätzlich geeignet erachtet, der Informa-tionsflut Herr zu werden, gibt es für die Wissenschaft undTechnik der nächsten Jahrzehnte noch genügend Aufga-ben zu lösen.

Nach einem Vortrag anlässlich der Verleihung des Rudolf-Keller-mann-Preises auf der 82. Jahrestagung der Deutschen Gesell-schaft für die Geschichte der Medizin, Naturwissenschaft undTechnik e. V., Leipzig, 26. September 1999.

Dr.-Ing.

Michael Friedewald (geb. 20.November 1965) hat Elektrotechnik, Wirt-schaftswissenschaften und Technikgeschichtean der RWTH Aachen studiert. Von1994–1999 war er Doktorand am dortigenLehrstuhl für Geschichte der Technik. SeinArbeitsschwerpunkt war die Geschichte derDatenverarbeitung. Heute ist er wissen-schaftlicher Mitarbeiter am Fraunhofer-Insti-

tut für Systemtechnik und Innovationsforschung in Karlsruhe.Seine Dissertation über die Geschichte des Personal Computingist auch als Buch erschienen: Michael Friedewald: Der Computerals Werkzeug und Medium: Die geistigen und technischen Wur-zeln des Personalcomputers. Aachener Beiträge zur Wissen-schafts- und Technikgeschichte des 20. Jahrhunderts, Band 3.Verlag für Geschichte der Naturwissenschaften und der TechnikBerlin und Diepholz 1999. 497 S., 117 Abb., 5. Tab., DM 75,30

Literatur[1] T. Nelson: Computer Lib/Dream Machines. (Erste Aufl. 1974).Tempus Books. Redmond 1987. — [2] H. H. Goldstine: The Com-puter from Pascal to von Neumann. Princeton University Press.Princeton 1980 — [3] B. Heintz: Die Herrschaft der Regel: ZurGrundlagengeschichte des Computers. Campus Verlag. Frankfurt,New York 1993. — [4] V. Bush, Atlantic Monthly 176, 1 (1945). —[5] K. C. Redmond, T. M. Smith: Project Whirlwind: The Historyof a Pioneer Computer. Digital Press. Bedford 1980. — [6] J. C. R.Licklider, IRE Transactions on Human Factors in ElectronicsHFE-1, 1 (1960). — [7] H. D. Hellige: Leitbilder im Time-Sharing-Lebenszyklus: Vom "Multi-Access" zur "Interactive Online-Com-munity". In H. D. Hellige (Hrsg.): Technikleitbilder auf dem Prüf-stand: Leitbild-Assessment aus der Sicht der Informatik- undComputergeschichte, S. 205–234. Edition Sigma. Berlin 1996. —[8] A. L Norberg, J. E. O'Neill: Transforming Computer Technolo-gy: Information Processing in the Pentagon 1962-1986. JohnsHopkins University Press. Baltimore Md. 1996. — [9] D. C. Engel-bart: A Conceptual Framework for the Augmentation of Man'sIntellect. In P. W. Howerton, D. C. Weeks (Hrsg.): The Augmenta-tion of Man's Intellect by Machine , S. 1-29. Spartan Books. Was-hington 1963. — [10] M. Friedewald, Technikgeschichte 67, 1(2000). — [11] D. C. Engelbart, W. K. English: A research centerfor augmenting human intellect. In Proceedings of the 1968 FallJoint Computer Conference, S. 9-21. Thompson Books. Washing-ton 1968. — [12] M. A. Hiltzik: Dealers of Lightning: Xerox PARCand the Dawn of the Computer Age. Harper Collins. New Yorker1999. — [13] A. C. Kay, A. Goldberg, IEEE Computer 10, 1 (1977).— [14] P. Ceruzzi, History and Technology 13, 1 (1996). — [15] M.L. Dertouzos, Technology Review 100, 3 (1997). — [16] A. C. Kay,Scientific American 251, 3 (1984). — [17] R. T. Dué, InformationSystems Management 10, 4 (1993). — [18] N. Postman, Die Zeitvom 9. Oktober 1992. — [19] V. Bush, LIFE 19(11), 112 (1945).

Friedewald: Die geistigen und technischen Wurzeln des Personal Computers

Naturwissenschaftliche Rundschau | 53. Jahrgang, Heft 4, 2000 171