Back-Propagation Pertemuan 5

-

Upload

adrian-hahn -

Category

Documents

-

view

36 -

download

0

description

Transcript of Back-Propagation Pertemuan 5

1

Back-Propagation Pertemuan 5

Matakuliah : T0293/Neuro Computing

Tahun : 2005

2

Konsep Dasar BP

• Solusi dari keterbatasan single-layer network• Penemuan algoritma BP merupakan kebangkitan

kembali paradigma “ neural computing “.• Nama-nama scientist yang memberi kontribusi

terhadap pengembangan BP – Rumelhart, Hinton dan Williams (1986)– Parker (1982)– Werbos (1974)

3

Konfigurasi Networks (BP) • Model Neuron

Artificial Neuron with Activation Function

F

NET

OUTET

OUT = 1 / ( 1 + e -

NET )

NET = O1 W1 + O2 W2 + ... + On Wn = Oi Wi

OUT = F ( NET )

W1

W2

Wn

O1

O2

On

4

Activation Function

Sigmoidal Activation Function

Ada beberapa fungsi yang dapat digunakan; Algoritma BP memerlukan fungsi yang bersifat ‘differentiable’

0 NET

OUT

OUT = F(NET)1 / ( 1 + e -NET )

F’ (NET) = OUT = OUT (1-OUT) NET

0.5

5

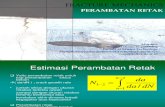

Model Multilayer Networks

• Model berikut adalah contoh multilayer networks yang sesuai untuk diterapkan dengan algoritma BP

6

INPUTLAYER

INPUTLAYER k

TARGET1

TARGET2

TARGETn

OUTn

OUT2

OUT1

W11

W22

W3m

W2m

W12

ERROR1

ERROR2

ERRORn

HIDDENLAYER j

Two-Layer Backpropagation Network

7

Network Training

Langkah-langkah Training 1. Pilih “ training pair “ ( berikutnya ); aplikasikan

vektor input ke dalam network2. Hitung output dari networks.3. Hitung error antara “ actual output “ dengan

‘target output’.4. Sesuaikan bobot dengan cara meminimumkan

error.5. Ulangi 1 sampai dengan 4 untuk setiap vektor

dalam ‘ training set ’.

8

Forward Pass

O = F ( X W ) dimana O adalah vektor output.

Vektor output dari suatu layer merupakan vektor input dari layer berikutnya. Dengan demikian perhitungan output akhir dari networks dilakukan perhitungan dengan rumus di atas pada setiap layer

9

Reverse Pass

Penyesuaian bobot pada ‘ output layer ’ :

= OUT (1-OUT) (Target-OUT) Wpq,k = q,k OUTp,j

Wpq,k (n+1) = Wpq,k (n) + Wpq,k

10

dimana

Wpq,k (n) = nilai bobot dari neuron p pada ‘hidden layer’ ke

neuron q pada ‘output layer’ pada langkah ke-n;

subscript k menunjukkan bahwa bobot berkaitan

dengan ‘destination layer’

Wpq,k (n+1) = nilai bobot pada langkah ke n+1

q,k = nilai untuk neuron q pada ‘output layer’ ke k

OUTp,,j = nilai OUT untuk neuron p pada ‘hidden layer’ j

Catatan:

Penyesuaian bobot pada hidden layer

p,,j = OUTp,,j (1- OUTp,,j) (q,k Wpq,k)